KI-Modelle sind schlau – aber oft schlecht vernetzt. Stell dir vor, dein Sprachmodell könnte direkt mit Tools und Daten sprechen – ganz ohne Integrationschaos. Genau das will MCP ermöglichen.

LLMs sind heute in vielen Anwendungen essentiell. Doch die Verbindung zu externen Systemen ist komplex und häufig mit hohem Entwicklungsaufwand verbunden. Das Model Context Protocol (MCP) von Anthropic wurde entwickelt, um genau das zu vereinfachen.

Was ist das Model Context Protocol (MCP)?

Anthropic beschreibt MCP als „USB-C für KI-Anwendungen“ – ein universeller Anschluss, über den sich verschiedenste Systeme nahtlos verbinden lassen. Der offene Standard bietet eine einheitliche Schnittstelle, die große Sprachmodelle direkt mit Tools und Datenquellen koppelt – ohne individuelle Anpassungen für jede Integration.

Warum wurde Model Context Protocol (MCP) eingeführt?

KI-Sprachmodelle sind heute leistungsstärker denn je. Doch in Unternehmensumgebungen stoßen sie an Grenzen, wenn es darum geht, relevante Informationen aus unterschiedlichen Quellen nutzbar zu machen. Individuelle Integrationen waren bisher die Regel – und wurden schnell zum Engpass für skalierbare Lösungen.

MCP löst dieses Problem: Als standardisierte Schnittstelle schafft es die Basis für relevantere Antworten und effizientere Workflows.

Durch MCP sparen Unternehmen erheblichen Entwicklungsaufwand. Individuelle Integrationen gehören der Vergangenheit an. Du kannst KI-Agenten schneller starten und flexibel erweitern – das spart Zeit, reduziert Kosten und erhöht die Skalierbarkeit deiner KI-Anwendungen.

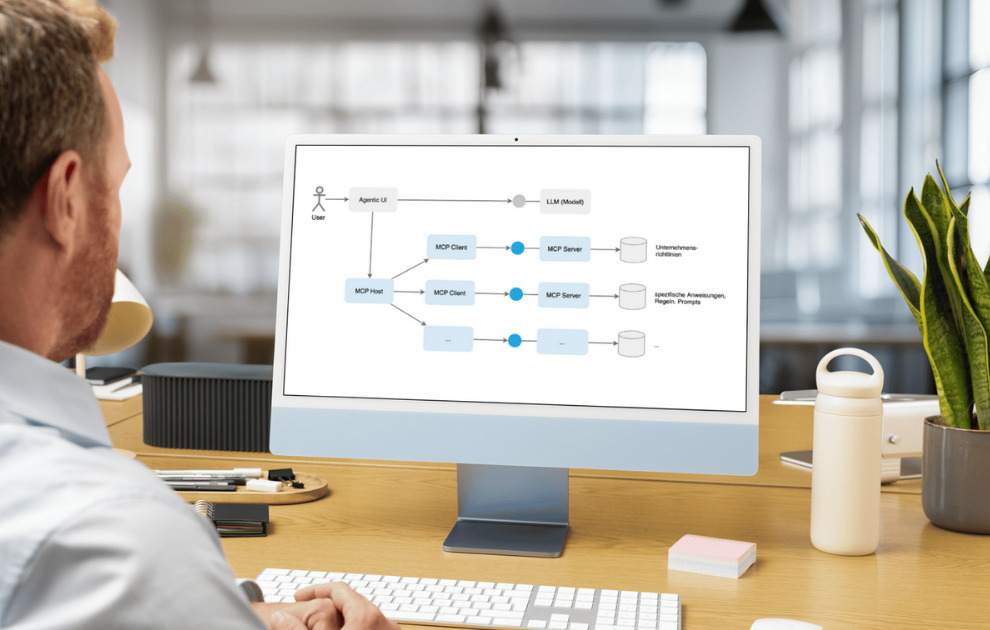

Die Architektur des Model Context Protocol (MCP) im Überblick:

MCP-Server: eigenständige Programme, die bestimmte Datenquellen oder Fähigkeiten bereitstellen, z. B. Zugriff auf das Dateisystem oder eine Datenbank.

MCP-Client: bindet sich an den Server an und vermittelt zwischen Modell und Datenquelle.

MCP-Host-Anwendung: etwa eine IDE, ein Chatbot oder ein Desktop-Client, der ein LLM verwendet.

Datenquellen und Tools: lokale Dateien, APIs, Webdienste, Datenbanken etc.

LLM: wird vom MCP-Host verwendet, um

zu verstehen, was der MCP-Host benötigt

Aufgaben in MCP-konforme Befehle zu übersetzen

So funktioniert MCP, Quelle: eigene Darstellung

MCP schafft einen bidirektionalen und indirekten Kanal zwischen Modell und externer Welt: Modelle können sowohl Daten lesen als auch Aktionen ausführen – z. B. Änderungen in einem Repository vornehmen oder eine neue Slack-Nachricht senden.

Die wichtigsten Vorteile von MCP

Standardisierung

MCP löst das Problem der fragmentierten Integrationen durch eine einheitliche Protokollstruktur. Statt zahlreiche individuelle Schnittstellen zu entwickeln, können Entwickler:innen mit einem einzigen Standard arbeiten.

Flexibilität

Dank MCP kann vergleichsweise leicht zwischen verschiedenen KI-Modellen und Datenquellen gewechselt werden, ohne größere Anpassungen am Gesamtsystem vornehmen zu müssen.

Sicherheit und Datenschutz

MCP gewährleistet Benutzerkontrolle und schützt sensible Daten durch sichere Kommunikationswege (z. B. TLS-verschlüsselte Verbindungen) und Sandbox-Mechanismen. Auf diese Weise bleiben kritische Ressourcen geschützt, während KI-Agenten dennoch über relevante Informationen verfügen.

Skalierbarkeit

MCP spricht viele Kommunikationswege wie HTTP, WebSockets, Server-Sent Events (SSE) und UNIX-Sockets , was eine dynamische und skalierbare Anbindung ermöglicht. Anwendungen lassen sich so leicht erweitern, ohne das gesamte System umbauen zu müssen.

Typische Einsatzszenarien: Vom Git-Commit bis zur Slack-Nachricht

Typische Anwendungen für MCP sind:

Codeassistenz mit Git-Integration

Zugriff auf Dateien oder Notizen

Kommunikation mit Slack, Google Drive, PostgreSQL

Interaktion mit DevOps-Tools oder Wissensdatenbanken

Der große Nutzen für Unternehmen besteht darin, dass neu hinzukommende Datenquellen oder Tools sich relativ einfach einbinden lassen – stets nach demselben Prinzip.

Welche Technologien stecken hinter MCP?

Laut den aktuellen Spezifikationen und Referenzen (z. B. docs.mcp.dev) werden folgende Standards und Technologien unterstützt bzw. empfohlen:

JSON-RPC 2.0 als zentrales Nachrichten- und Methodenaufrufschema

Definiert das Format für Requests, Responses und Fehlermeldungen

Ermöglicht eine einheitliche Struktur für Funktionsaufrufe und Rückgaben

Transportwege:

HTTP (inkl. TLS-Verschlüsselung)

WebSockets (für bidirektionale Kommunikation in Echtzeit)

Server-Sent Events (SSE) (für ereignisbasierte Datenübertragung)

STDIO und UNIX-Sockets (besonders in lokalen oder containerisierten Umgebungen)

Authentifizierung & Autorisierung:

Prinzipiell frei wählbar (z. B. OAuth2, JSON Web Tokens), aber die MCP-Spezifikation empfiehlt klar definierte Auth-Protokolle für Zugriffssteuerung

Optional können MAC- oder Token-basierte Mechanismen genutzt werden

Erweiterbarkeit:

Eigene Transportadapter lassen sich hinzufügen

Community-Server können spezifische „Capabilities“ wie Git- oder Datenbankzugriff bereitstellen

Durch modularen Aufbau ist es möglich, weitere Protokolle (z. B. gRPC) zu integrieren

Sicherheitsmechanismen:

Verschlüsselung (TLS/SSL) für Netzwerkkonnektivität

Rollenbasierte Zugriffsverwaltung auf einzelne Funktionen (z. B. getFile, writeFile, commitChanges)

Sandbox-Ansätze, um Aktionen nur im erlaubten Kontext zuzulassen

Dadurch bietet MCP nicht nur ein standardisiertes Interface für KI-Agenten, sondern auch vielfältige Optionen, um je nach Anwendungsfall die passende Kommunikations- und Sicherheitsinfrastruktur zu wählen.

Wie funktioniert MCP konkret?

Einbindung

Entwickler:innen nutzen offizielle SDKs (Python, TypeScript, Java, C#) oder bauen eigene Server mit JSON-RPC. Der Server stellt „Capabilities“ bereit, z. B. getFile, search, writeFile.

Ein KI-Agent nutzt diese Fähigkeiten über den MCP-Client. Typischer Ablauf:

Host-App startet oder verbindet einen MCP-Client.

Der Client verbindet sich mit einem oder mehreren MCP-Servern.

Die verfügbaren Funktionen (Methoden) werden automatisch erkannt.

Das Modell kann bei Bedarf den Server ansprechen, um Daten zu erhalten oder Aktionen auszulösen.

Beispiel: Funktion ändern & committen per MCP

1. User Prompt:

„Setze den Wert von MAX_THRESHOLD in constants.ts auf 500 und committe die Änderung mit Nachricht: ‚Erhöhe Threshold auf 500‘.“

2. LLM erkennt die Absicht:

Datei muss geändert werden

Code anpassen

Commit auslösen

3. Host ruft über MCP getFile auf, um den aktuellen Stand zu laden:

{

„jsonrpc“: „2.0“,

„id“: 1,

„method“: „getFile“,

„params“: {

„path“: „src/config/constants.ts“

}

}

4. Modell generiert neuen Inhalt

(basierend auf alter Version + Änderungswunsch)

Beispiel-Inhalt nach Änderung:

export const MAX_THRESHOLD = 500;

5. Host ruft commitChanges auf:

{

„jsonrpc“: „2.0“,

„id“: 2,

„method“: „commitChanges“,

„params“: {

„changes“: [

{

„path“: „src/config/constants.ts“,

„newContent“: „export const MAX_THRESHOLD = 500;“

}

],

„message“: „Erhöhe Threshold auf 500“

}

}

6. MCP-Server antwortet mit Commit-Erfolg:

{

„jsonrpc“: „2.0“,

„id“: 2,

„result“: {

„commitSha“: „a3b9cfe1“,

„status“: „success“

}

}

Ergebnis:

Der Agent konnte kontextsensitiv Code verstehen, ändern und speichern.

Der ganze Vorgang läuft über MCP strukturiert und sicher, ohne dass das Modell direkt „Git“ sprechen muss.

Sequenzdiagramm Dateiänderung mit MCP, Quelle: eigene Darstellung

Risiken und Herausforderungen im Umgang mit MCP

Technisch

Fehlerhafte Integrationen können falsche Daten liefern oder Aktionen auslösen.

Community-basierte Server könnten unzureichend geprüft sein.

Ohne stabile Schnittstellen droht Instabilität bei API-Änderungen.

Sicherheit

Modelle könnten Aktionen auslösen, die nicht autorisiert sind.

Prompt-Injection kann zu gefährlichem Verhalten führen.

Zugriffsrechte auf Daten und Schreibfunktionen müssen exakt konfiguriert sein.

Fehlende Authentifizierung oder Verschlüsselung kann zu Datenlecks führen.

Ethisch

Wer haftet für Fehlentscheidungen eines KI-Agenten?

Wie verhindert man, dass Agenten unerwünschte Änderungen an Systemen vornehmen?

Wie lässt sich nachvollziehen, was ein Agent aus einem Kontext gelernt und genutzt hat?

Fazit: MCP als Rückgrat der Agenten-Zukunft – mit Potenzial und beherrschbarem Risiko

MCP bringt eine klare Antwort auf ein zentrales Problem: Wie kann ein KI-Agent zuverlässig mit seiner Umgebung interagieren, ohne jedes System individuell anzubinden? Die Vision: Ein modularer, wiederverwendbarer Steckplatz für Kontext und Tools.

Ein konkretes Beispiel aus der Praxis ist der doubleSlash AI Assistant, der bereits erfolgreich auf Basis der MCP-Architektur aufgebaut ist und dadurch flexibel und effizient mit unterschiedlichen Unternehmensdatenquellen interagiert.

Auch Firmen wie Replit, Sourcegraph, OpenAI und viele mehr nutzen bereits MCP oder arbeiten an der Integration. Langfristig könnte MCP ein zentraler Standard für die Agentenarchitektur werden – ähnlich wie REST für APIs oder USB für Hardware.

Ein denkbares Zukunftsszenario: KI-Agenten mit sicherem, strukturiertem Zugriff auf ein ganzes Ökosystem an Fähigkeiten – vom Finanzreport über Softwaretests bis hin zur Vertriebsanalyse. Alles über einen einheitlichen Protokollstandard.

Die Risiken sind real – aber beherrschbar. MCP könnte das Rückgrat einer neuen Agenten-Ära sein: sicher, offen und leistungsfähig.1

Dieser Beitrag wurde gemeinsam von Konrad und Manuel geschrieben.

Über Mich

Manuel Bauer

Manuel Bauer hat einen Bachelor of Science in Wirtschaftsinformatik, ist Software Engineer bei doubleSlash und bringt fundierte Erfahrung aus IT-Projekten mit Kunden wie BMW, Porsche und Vorwerk mit.

Sein Schwerpunkt liegt auf komplexen IT-Systemen, Cloud-Infrastrukturen und der Entwicklung cloud-nativer Softwarelösungen. Aktuell fokussiert er sich besonders auf den Einsatz von Künstlicher Intelligenz in der Softwareentwicklung.

Fachlich versiert in Requirements Engineering, Java, Python, Cloud-native Application Development, SQL/NoSQL, KI und DevOps, verbindet er technisches Know-how mit einem Blick für ganzheitliche Lösungen.

GitHub – anthropics/mcp Repository

OpenAI Developer Day 2023 – Diskussion zu MCP-Kompatibilität von ChatGPT

MCP Protocol Spezifikation – Dokumentation auf https://docs.mcp.dev

Claude Desktop App – MCP-Integration (Anthropic Blog)

SDKs und Tools – GitHub-Repositories von Anthropic

Beispiele für MCP-Server – GitHub Repos (z. B. mcp-slack, mcp-files, mcp-postgres)

JSON-RPC 2.0 Specification – jsonrpc.org/specification ︎

Der Beitrag MCP – Der Universalstecker für KI? erschien zuerst auf Business -Software- und IT-Blog – Wir gestalten digitale Wertschöpfung.