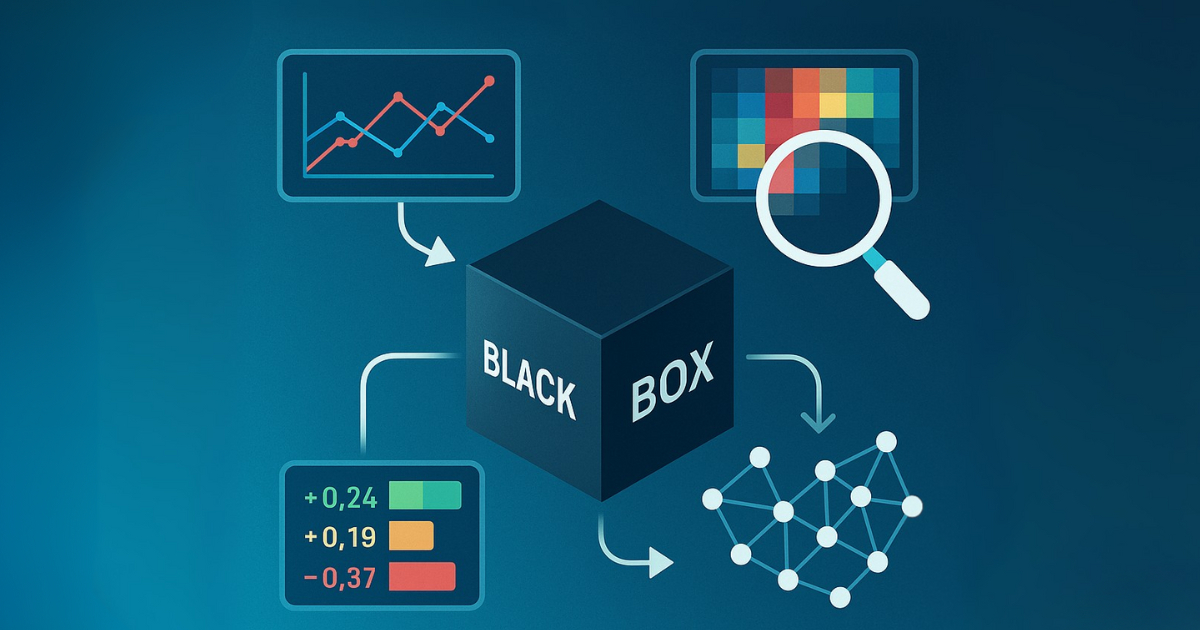

Wie lässt sich die Blackbox KI erklären? Teil 2 zeigt, mit welchen Methoden Explainable AI arbeitet und warum Transparenz entscheidend für ethische KI ist.

Im ersten Teil haben wir gezeigt, warum Explainable AI (XAI) die Grundlage für vertrauenswürdige und verantwortungsvolle KI ist. Jetzt gehen wir einen Schritt weiter und zeigen, wie XAI konkret funktioniert, welche Methoden es gibt und welche ethischen Herausforderungen damit verbunden sind.

Methoden der Explainable AI

Transparente Modelle

Einige Modelle sind von Natur aus erklärbar – man nennt sie auch „interpretierbar“. Dazu zählen lineare Regressionsmodelle und Entscheidungsbäume. Diese Modelle besitzen folgende Eigenschaften:

Simulierbarkeit: Menschen können das Modell und sein Verhalten nachvollziehen – etwa wie sich einzelne Eingaben auf die Ausgabe auswirken.

Zerlegbarkeit: Jeder Bestandteil, ob Eingabewert oder Hyperparameter, ist nachvollziehbar. Pixelwerte eines Bildes sind hier z. B. schwierig, da sie zu abstrakt sind.

Algorithmische Nachvollziehbarkeit: Der zugrundeliegende Algorithmus ist transparent und verständlich. So lässt sich analysieren, wie ein lineares Modell z. B. Risikofaktoren gewichtet.

Ein einfacher Entscheidungsbaum zur Bestimmung des Risikos eines Herzinfarkts , Quelle1

Post-hoc-Erklärungen

Nicht jedes KI-Modell ist von Natur aus verständlich. Viele leistungsfähige Modelle, wie neuronale Netze oder Ensemble-Verfahren, gelten als sogenannte Blackbox-Modelle: Ihre internen Abläufe sind komplex und für Menschen kaum durchschaubar. Gerade hier ist Explainability besonders wichtig.

In solchen Fällen kommen Post-hoc-Methoden zum Einsatz.

Der Begriff „Post-hoc“ bedeutet: Die Erklärbarkeit wird nachträglich erzeugt, also nicht im Modell selbst, sondern zusätzlich aufgebaut. Diese Methoden sind entscheidend, wenn es um Modelle mit nichtlinearen oder sehr komplexen Strukturen geht, etwa bei Sprachmodellen, medizinischer Diagnostik oder in der Bildverarbeitung.

Modell-spezifisch vs. modell-agnostisch

Modell-spezifisch: Hier wird versucht, das Innenleben eines bestimmten Modells gezielt zu analysieren – also z. B. welche Schichten eines neuronalen Netzes welche Informationen verarbeiten.

Modell-agnostisch: Statt das Modell selbst zu untersuchen, wird nur der Zusammenhang zwischen Input und Output betrachtet. Durch gezielte Änderungen an den Eingabedaten lassen sich Rückschlüsse auf die Entscheidungslogik ziehen – unabhängig vom Modelltyp.

Bei den post-hoc Technologien sind besonders die beiden Ansätze SHAP und LIME vielversprechend.

Tools im Fokus: SHAP, LIME & Co.

SHAP (Shapley Additive Explanations) basiert auf Konzepten der Spieltheorie und bewertet den Einfluss einzelner Merkmale auf die Vorhersage eines Modells. Die Methode unterstützt sowohl globale Erklärungen – etwa in Form von Balkendiagrammen oder sogenannten Beeswarm-Plots – als auch lokale Analysen wie Force-Plots oder Heatmaps.

SHAP hat sich in zahlreichen Anwendungsfeldern etabliert: von der medizinischen Risikobewertung über die Vorhersage von Betonverhalten bis hin zur Erkennung von Ölverschmutzungen oder Spam-Inhalten. Auch bei doubleSlash kommt SHAP zum Einsatz, zum Beispiel in der Lösung zur intelligenten Störungserkennung und Wartungsplanung.

LIME (Local Interpretable Model-Agnostic Explanations) verfolgt einen anderen Ansatz. Es verändert lokal einzelne Datenpunkte und erstellt daraufhin ein einfaches, lineares Modell, das als Erklärungsmodell dient. LIME eignet sich besonders für Textdaten, Bilder oder strukturierte Daten. Es macht sichtbar, welche Wörter, Bildbereiche oder Merkmale entscheidend zur Vorhersage beigetragen haben – und bietet somit lokal gültige, intuitive Einblicke. Auch hier findet sich ein Beispiel aus der Immobilienbewertung: Die Distanz zum Stadtzentrum ist das stärkste Merkmal – und LIME kann diese Bedeutung durch eine visuelle Darstellung nachvollziehbar machen.

Die Distanz zum Stadtzentrum hat die höchste Auswirkung auf den Preis dieses Hauses, Quelle3

Auch bildbasierte Verfahren tragen zur Explainability bei. Besonders in der Objekterkennung kommen Heatmaps zum Einsatz. Sie markieren jene Bildbereiche, die besonders stark zur Vorhersage beitragen – häufig in Rot hervorgehoben. So wird erkennbar, worauf das Modell tatsächlich „blickt“ – etwa bei der Unterscheidung von Fahrzeugtypen oder bei der Erkennung medizinischer Auffälligkeiten.

Beispiel für die Veranschaulichung der Erkennung und Klassifizierung verschiedener Fahrzeuge. Besonders ausschlaggebende Bereiche sind rot unterlegt.

Ethische Herausforderungen von XAI

Mit XAI lassen sich Verzerrungen sichtbar machen – doch sie lösen nicht automatisch alle Probleme. Eine der größten Herausforderungen ist der Umgang mit unausgewogenen Trainingsdaten. Besonders bei Gesichtserkennungstechnologien kommt es häufig zu Diskriminierung: Frauen und ethnische Minderheiten werden deutlich häufiger falsch klassifiziert als weiße Männer. Der Grund liegt oft in der mangelnden Repräsentation in den Trainingsdaten.

Auch generative KI birgt ethische Risiken. Sprachmodelle können ungewollt Hassrede, Fehlinformationen oder psychisch gefährdende Inhalte generieren. Diese Inhalte wirken besonders problematisch, wenn sie als glaubwürdige Antworten erscheinen – etwa in Beratungssituationen.

Zudem können historische Voreingenommenheiten aus Datensätzen reproduziert werden – wie im Fall von ADHD-Diagnosen, die bei Frauen seltener erkannt wurden. Ohne erklärbare Modelle bleiben solche Verzerrungen unsichtbar und können schwerwiegende gesellschaftliche Folgen haben.

Praxisbeispiele von XA

Explainable AI wird in zahlreichen Anwendungsbereichen bereits heute eingesetzt:

Generative KI: Generative Modelle wie ChatGPT können Verzerrungen aufweisen, Fehlinformationen verbreiten oder irreführende Antworten liefern. XAI hilft dabei, solche Modelle transparenter zu machen, indem es aufzeigt, wie Nutzereingaben verarbeitet werden und welche Faktoren die Ergebnisse beeinflussen. Lokale Erklärungen, etwa durch farbliche Markierungen bei hoher Vertrauenswürdigkeit oder Quellennachweise bei medizinischen Fragen, ermöglichen eine bessere Einschätzung der Informationsqualität – und stärken so das Vertrauen in die Modelle.

Medizinische Diagnostik: Im Gesundheitswesen hat verantwortungsvolle KI eine besonders große Bedeutung, da Entscheidungen direkt das Leben von Menschen betreffen. Historische Verzerrungen, wie etwa die Unterdiagnostik von ADHD bei Frauen und ethnischen Minderheiten, können durch XAI sichtbar gemacht werden. Tools wie SHAP oder LIME helfen, aufzuzeigen, auf welchen Merkmalen Diagnosen beruhen, und ermöglichen Ärzten sowie Aufsichtsbehörden, Entscheidungen nachzuvollziehen. So lassen sich Fairness, Transparenz und Patientensicherheit stärken.

Autonome Fahrzeuge: Bei autonomen Fahrzeugen kann ein Fehler fatale Folgen haben. XAI macht Entscheidungen nachvollziehbar – etwa wenn ein Tempolimit erkannt und daraufhin beschleunigt wird. Diese Transparenz erlaubt es Nutzer:innen, das Verhalten des Fahrzeugs zu verstehen und bei Bedarf einzugreifen. Gleichzeitig schafft sie die Basis für rechtliche Verantwortung der Hersteller im Falle eines Unfalls. Rückmeldungen auf erklärbare Entscheidungen helfen zudem, die Systeme kontinuierlich robuster und fairer zu gestalten. Selbst Datenschutzfragen – etwa beim schwarmbasierten Lernen – lassen sich so verantwortungsvoll adressieren.

Fazit: Vertrauen in KI beginnt mit Verständnis – und endet bei der Methode

Explainable AI ist mehr als nur ein technisches Feature. Sie ist ein ethisches Muss, um Vertrauen zu schaffen, Diskriminierung zu erkennen und Verantwortung sicherzustellen.

Ob bei Chatbots, Diagnosen oder autonomen Fahrzeugen – XAI sorgt dafür, dass KI nicht nur funktioniert, sondern auch verstanden wird. Nur so kann sie gesellschaftlich akzeptiert und verantwortungsvoll genutzt werden.

Welche Prinzipien und Anforderungen eigentlich hinter Responsible AI stehen – und warum Explainability dafür die Grundlage bildet – erfährst du in Teil 1 der Beitragsreihe.

Der Beitrag Wie funktioniert Explainable AI? erschien zuerst auf Business -Software- und IT-Blog – Wir gestalten digitale Wertschöpfung.